Source : La Quadrature du Net, 21-06-2019

La Quadrature du Net est contre la reconnaissance faciale, d’accord : mais pourquoi ? Dès qu’on aborde le sujet en public, on voit se dessiner deux attitudes opposées. D’un côté, le solide bon sens qui ne voit pas pourquoi on se priverait de la possibilité d’identifier efficacement les criminels dans une foule, et pour qui tous les moyens sont bons, puisque la fin est juste. De l’autre côté, la peur réflexe devant cette technique de surveillance – souvent plus vive que devant d’autres techniques de surveillance pourtant très répandues – parce qu’elle est exploitée au cinéma comme outil d’un pouvoir policier totalitaire. C’est entre ces deux pôles, fantasme contre fantasme, qu’on peut essayer de comprendre les enjeux de la reconnaissance faciale.

Reconnaissance facile

Un terroriste est en fuite dans les rues d’une capitale : il suffit d’analyser en direct les images des caméras de surveillance de la ville pour le situer en quelques minutes. Un enfant s’est perdu ? Vite, les caméras de tous les lieux publics sont interrogées, et l’enfant est retrouvé en moins d’une demi-heure.

Les personnes chargées de vendre des systèmes de reconnaissance faciale ne manquent pas d’imagination pour convaincre le grand public de l’efficacité de leurs produits. Le contexte sécuritaire, accentué par les attaques terroristes de 2015, entretenu par le personnel politique et amplifié par les médias de masse, leur ouvre un boulevard idéologique et des lignes de crédit généreuses.

Autant dire qu’en matière de fantasme, les partisans de la reconnaissance faciale généralisée ne sont pas en reste. Le seul fait que la surveillance permanente des rues et des espaces publics soit considérée comme une solution miracle à l’insécurité dans la société devrait suffire à disqualifier l’outil : il est incapable de répondre aux objectifs qu’on veut lui donner.

Comment ça marche ?

Il existe plusieurs types de reconnaissance faciale. Leur point commun, c’est un logiciel capable de repérer dans une image (photo ou vidéo) des structures de visage et de les comparer point à point avec d’autres images. Il faut ensuite distinguer deux formes de « reconnaissance ».

Si on compare les images avec d’autres images de la même source – les différents angles de vue dans une galerie commerciale, par exemple – alors on veut « identifier » quelqu’un : c’est-à-dire isoler une personne (« identique » à elle-même !) parmi d’autres et la suivre ainsi dans ses déplacements, soit parce qu’on estime qu’elle a un comportement suspect, soit pour renseigner la galerie commerciale sur le parcours de ses clients.

Quand on reconnaît les visages dans une foule pour les comparer à un jeu de visages de personnes recherchées, il s’agit aussi de les « identifier ».

En revanche, on, parle d’« authentification » quand on compare le visage d’une personne à un visage de référence. L’authentification est couramment utilisée comme système de déverrouillage : le visage saisi par la caméra doit correspondre à l’image enregistrée dans un badge (c’est le cas du système prévu pour les lycéesde PACA) ou dans une base de donnés de personnes autorisées (par exemple à l’entrée d’une entreprise). C’est un procédé testé aussi pour le retrait d’argent à un distributeur, en renfort du PIN.

C’est le seul exemple où la reconnaissance faciale vise toujours à protéger la confidentialité des données et l’intimité de la personne : quand on choisit de déverrouiller son téléphone avec la reconnaissance faciale, c’est parce qu’on espère que personne d’autre ne pourra le faire.

L’identification est utilisée par la police pour reconnaître des personnes recherchées. On peut en voir un exemple concret et efficace sur le site d’Interpol.

Des exemples comme celui-ci alimentent le fantasme qui sous-tend la reconnaissance faciale : si on peut scanner tous les passants et identifier ceux qui sont suspects, alors la criminalité reculera et la sécurité augmentera.

Méconnaissance faciale

Mais le moindre défaut de la reconnaissance faciale, c’est qu’elle ne marche pas très bien. On le sait parce que de nombreuses expériences sont conduites dans le monde, et que les résultats publiés sont assez étonnants, en comparaison des espoirs démesurés que suscite la technique.

La société SenseTime, en Chine, se vante par exemple de pouvoir identifier un individu qui commet une « incivilité » dans la rue, afin d’afficher son visage sur des écrans géants et le soumettre au mépris public. Mais une expérience menée aux États-Unis s’est conclue sur le constat que la reconnaissance faciale sur des automobilistes ne fonctionne pas encore.

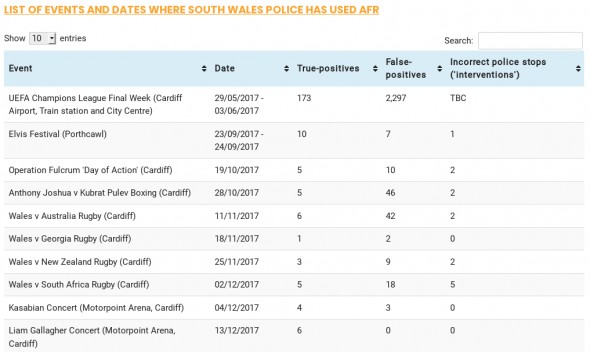

Ce document fuité par la police britannique recense, pour chaque expérience de reconnaissance faciale (Event), le nombre d’identifications réussies (True-positives), le nombre de faux positifs (False-positives), et le nombre d’interpellations injustifiées (Incorrect police stops).

Nos collègues anglais de Big Brother Watch, au Royaume-Uni, qui militent notamment contre l’utilisation de la reconnaissance faciale, ont publié des chiffres à propos des expériences menées par la police britannique. Ils montrent que le taux de reconnaissance est très bas, et que les « faux positifs », c’est-à-dire les identifications erronées, sont nombreuses. Certaines ont même entraîné des interventions infondées de la police.

La sécurité des forts

L’échec des identifications n’est pas imputable seulement à un défaut de la technique : le germe de l’échec est dans les hommes qui programment la reconnaissance faciale. Le logiciel qui analyse les visages et les compare à d’autres visages est dans la plupart des cas conçu par des hommes blancs. Surprise : la reconnaissance faciale des femmes et des personnes non-blanches atteint un taux d’échec et de faux positifs supérieur à la moyenne.

Que ses concepteurs le veuillent ou non, ce qu’on appelle « les biais de l’algorithme », ses effets indésirables, sont en réalité les biais cognitifs de ceux qui le conçoivent : le racisme et le sexisme de l’algorithme dérivent du racisme et du sexisme institués par la société, et consciemment ou inconsciemment reproduits par les concepteurs de ces outils.

Cet article donne plusieurs exemples des effets de ce biais.

Dans le cadre d’un usage policier de la reconnaissance faciale, les personnes les plus faibles socialement seront ainsi plus souvent victimes d’erreurs policières que les autres.

Société de contrôle

Les philosophes Michel Foucault et Gilles Deleuze ont défini de façon très précise plusieurs types de coercitions exercées par les sociétés sur leurs membres : ils distinguent en particulier la « société disciplinaire » (telles que la société en trois ordres d’Ancien Régime ou la caserne-hôpital-usine du XIXe siècle) de la « société de contrôle » qui est la nôtre aujourd’hui.

Dans une « société de contrôle », les mécanismes de coercition ne sont pas mis en œuvre par des autorités constituées qui les appliquent au corps social par contact local (autorité familiale, pression hiérarchique dans l’usine, surveillant de prison, etc.), mais sont incorporés par chacun (métaphoriquement et littéralement, jusqu’à l’intérieur du corps et de l’esprit), qui se surveille lui-même et se soumet à la surveillance opérée par d’autres points distants du corps social, grâce à une circulation rapide et fluide de l’information d’un bord à l’autre de la société. Wikipédia donne un bon aperçu du concept, dont on trouvera une lecture plus approfondie ici.

Qui peut souhaiter d’être soumis à un contrôle dont les critères lui échappent ? C’est pourtant ce que nous acceptons, en laissant s’installer partout la vidéosurveillance et la reconnaissance faciale.

La mairie de Nice, dirigée par par Christian Estrosi (LR), a fait scandale au printemps 2019 en organisant une expérience lors du carnaval de la ville. Sur la base du volontariat, certaines personnes préalablement identifiées devaient être reconnues dans la foule. Mais la ville de Nice envisage d’aller plus loin, en authentifiant les passagers du tramway dont le comportement serait « suspect ».

Qu’est-ce qui définit un comportement suspect ? Avoir un type maghrébin et un sweat à capuche entre sûrement dans les critères. Mais quoi d’autre ? Une expression faciale fermée, une nervosité visible ? Quelles émotions sont-elles considérées comme étant un danger pour la société ? Où peut-on consulter la liste ? On voit bien la part fantasmatique et arbitraire qui fonde tout projet d’anticiper la criminalité.

Sous prétexte que « prévenir vaut mieux que guérir », on organise en réalité, dans des usages quotidiens bien réels et valables dès aujourd’hui, une inversion générale de la charge de la preuve.

En temps normal, la police judiciaire doit rassembler par l’enquête des preuves à charge pour inculper quelqu’un. C’est à l’accusation de faire la preuve de la culpabilité du suspect. Ce travail est collectif, encadré par une procédure et un tribunal.

En revanche, sous l’œil de la caméra et face aux algorithmes de reconnaissance faciale, c’est à chacun que revient, à tout instant et en tout lieu, la charge de prouver son innocence. Comment ? En offrant son visage à l’identification et en adoptant un comportement qui ne déclenchera aucune alarme au fond d’un ordinateur de la police.

La loi de l’œil

On peut penser qu’il s’agit, sous nos yeux, d’un choix de société délibéré. En l’absence de cadre juridique clair, les dispositifs de reconnaissance faciale s’installent dans la hâte, avec un effet immédiat : chacun intériorise la contrainte de la surveillance et adapte insensiblement son comportement à ce regard abstrait. Il est psychologiquement naturel et moins coûteux de s’y plier, même avec une ironie protectrice, plutôt que de remettre en cause les décisions arbitraires qui sont imposées sans discussion.

L’intériorisation de la surveillance, la culpabilité par défaut, s’accompagne d’un ajustement inconscient à une loi non écrite. C’est l’effet Hawthorne, sorte d’effet placebo mental : savoir qu’on est surveillé modifie l’attitude. La surveillance n’a pas besoin de punir chaque individu pour s’exercer sur tous.

Refuser la reconnaissance faciale est une première nécessité, l’encadrer par la loi écrite aussi. (L’encadrement juridique de la reconnaissance faciale fera l’objet d’un article à part.)

Éducation au contrôle

Pourquoi vouloir installer un dispositif de reconnaissance faciale à l’entrée d’un lycée ? C’est en cours à Marseille et à Nice, un projet encore porté par monsieur Estrosi, et combattu par La Quadrature du Net. Quel intérêt, alors que des surveillants à l’entrée de l’établissement pourraient tout aussi bien reconnaître les élèves autorisé·es, repérer les intrus, et affronter les problèmes éventuels avec humanité ? La réponse est triste : parce que la machine est censée être moins chère.

La dépense s’amortit en quelques années et les services publics croient faire ainsi des économies, dans un contexte général où les problèmes sociaux sont délégués à l’entreprise privée ou plus souvent laissés à l’abandon, et abordés sous l’angle unique de la répression.

L’installation de caméras est le signe assez sûr d’une politique qui a baissé les bras. La reconnaissance faciale pousse seulement le curseur plus loin dans la prise en charge des relations humaines par des arbres de décisions préprogrammés. On renonce ostensiblement à l’ambition de construire une société.

Bénéfices et usage commerciaux

Les bénéfices attendus de la reconnaissance faciale sont en grande partie des mesures d’économie : moins de personnel pour surveiller de plus grandes surfaces urbaines, et un meilleur ajustement des moyens d’interventions. Les expériences de « safe city » menées aux États-Unis (Chicago, Detroit, en particulier) avaient par exemple pour but de mieux définir les quartiers et les rues où les patrouilles devaient circuler, en fonction des heures de la journée et même des saisons, pour être au plus près des faits de délinquances à réprimer. Dans la logique de la moindre dépense et de la réduction des effectifs, il faut bien « optimiser » le temps de présence des agents et le peu de moyens dont on dispose. Malheureusement, le raisonnement est faussé : les dispositifs techniques de vidéosurveillance exigent un entretien très coûteux. Les communes ne feront aucune économie, et financent les caméras avec des sommes qui manquent cruellement sur d’autres lignes de leur budget. Entre temps, elles auront supprimé un certain nombre de salarié·es.

Mais il ne faut pas perdre de vue que la reconnaissance faciale est également un « marché » aux bénéfices importants.

Pour l’heure, les entreprises se livrent à une course pour concevoir les outils et trouver des villes où les essayer. Ça tombe bien, les villes sont en demande : des appels d’offre plus ou moins transparents sont donc lancés un peu partout en France, alors que la transparence des décisions finales est inexistante (lire notre article), et tandis que les communes sabrent les subventions, l’argent magique ne semble pas manquer pour payer des « solutions » sécuritaires à grand frais, en vue des échéances électorales qui approchent.

Derrière l’engouement pour la vidéosurveillance et la reconnaissance faciale, on voit une convergence d’intérêts entre un agenda politique qui joue volontiers sur la corde de la sécurité publique, et des entreprises qui cherchent à s’emparer de l’immense marché municipal qui s’ouvre à elles, en France d’abord, et dans le monde ensuite.

Le profit à tirer de la reconnaissance faciale ne s’arrête pas là. On voit la technique s’installer aussi dans des centres commerciaux. Les caméras sont le plus souvent cachées dans les panneaux d’informations qui affichent le plan de la galerie commerciale, comme au Québec ou dans des « totems » qui affichent des vidéos publicitaires. Les réactions des passants sont épiées : quelles images retiennent leur attention, quelles boutiques envisagent-ils de visiter, quels sont leurs déplacements, etc. Le but étant bien sûr d’offrir aux visiteurs « la meilleur expérience possible »…

À aucun moment le consentement des passants n’est demandé, et on ne voit pas bien comment il pourrait l’être, sauf à leur donner le choix entre subir la vidéosurveillance ou quitter les lieux. Devra-t-on bientôt faire ses courses avec un sac sur la tête ?

La question du consentement est centrale dans la protection des données personnelles et de la vie privée, elle est d’ailleurs au centre des exigences du RGPD. Ce n’est donc pas un argument léger. Les lois européennes disent aussi que le consentement ne peut pas être obtenu en échange d’un service qui reviendrait à lui donner une valeur marchande : justifier la reconnaissance faciale dans les galeries commerciales en prétextant que les clients auront de meilleurs prix ou de meilleures offres n’est pas un argument recevable. C’est au pire un cache-misère pour l’avidité sans limite des marchands, qui traitent tous les passants comme des proies.

Les utilisations commerciale ou municipales de la reconnaissance faciale prospèrent dans une faille juridique : le phénomène est mal encadré, alors qu’il devrait faire l’objet d’un débat collectif. Mais la sécurité policière et la prospérité des entreprises commerciales sont devenues dans le monde entier l’alpha et l’oméga des politiques publiques.

La possibilité d’interdire

Les personnes les mieux averties des applications de la reconnaissance faciale sont tellement inquiètes qu’elles demandent un encadrement juridique de cette technique. C’est la leçon qu’on peut tirer de la lecture des articles écrits par Brad Smith, juriste de Microsoft. En juillet 2018, il appelait le gouvernement américain à légiférer sans délai pour encadrer les usages de la reconnaissance faciale. Bien placé pour constater les progrès de la technique, il redoute avec gravité qu’elle puisse être utilisée contre les libertés des personnes, aussi bien par des entreprises privées que par des États. En décembre 2018, il pose quelques jalons pour délimiter le contour de cet encadrement.

On n’est pas obligé de partager son enthousiasme pour certaines applications « positives » de la reconnaissance faciale, dont il donne quelques exemples qui mériteraient d’être regardés de plus près (dans la recherche médicale par exemple). Mais on peut entendre son inquiétude, parce qu’elle n’est pas celle d’un militant habitué à crier au loup : au plus haut niveau de décision, là où une vision panoramique peut embrasser à la fois la connaissance du droit et la connaissance des projets techniques réels, on n’en mène pas large, et ce n’est pas bon signe.

Toutefois, l’empressement de Brad Smith à voir naître une réglementation peut aussi être lu différemment, quand on le rapproche des déclarations récentes de Andy Jassy, président de Amazon Web Services, qui développe le logiciel Rekognition. Il se trouve qu’entre les articles de Brad Smith et l’interview de Andy Jassy, un événement important est survenu : la ville de San Francisco, en Californie, au plus près de la Silicon Valley et des grands sièges des multinationales du numérique, a voté le 14 mai 2019 une décision interdisant à la police locale d’utiliser la reconnaissance faciale. Amazon veut une réglementation parce que l’interdiction pure et simple ne fait pas de bien à ses affaires…

Quant à nous, nous retiendrons qu’il est possible d’interdire les pratiques de surveillance de masse, par la délibération locale et par la loi.

Le visage perdu

La reconnaissance faciale change le visage du monde. Il n’est pas nécessaire de renvoyer aux pires dystopies et à 1984 pour voir tout ce que les pratiques actuelles ont de dangereux. On peut même percevoir un changement anthropologique possible dans le rapport avec le visage.

La reconnaissance faciale attribue au visage, non plus une valeur de personnalité, l’expression même de la singularité d’une personne humaine, mais une fonction de dénonciation : le visage ne vaut plus pour lui-même, comme singularité prise avec son épaisseur et son secret, mais comme simple signe en lien avec des bases de données de toutes sortes qui permettent de prendre des décisions concernant la personne visée, à son insu.

Dans ce contexte, le visage devient l’identifiant unique par excellence, plus encore que la carte d’identité. Lors de l’expérience du carnaval de Nice, la ville se vantait même d’avoir pu identifier un cobaye dont la photo de référence datait de trente ans. Le visage comme mouchard, le visage qui trahit, merveilleux progrès.

On peut s’opposer à un prélèvement d’ADN. Mais comment s’opposer aux photos de soi ? Facebook applique un logiciel de reconnaissance faciale aux photos postées par ses utilisateurs. Si un « ami » n’est pas reconnu, le site invite même les utilisateurs à identifier leurs proches. Même en n’ayant jamais eu de compte Facebook, vous figurez peut-être dans cette immense base de données, et Facebook sait mettre votre nom sur votre visage, et vous reconnaître parmi toutes les nouvelles photos postées par vos amis…

Malgré vous, votre visage a un sens pour les caméras qui vous filment. Les pseudo-sciences du 19e siècle prétendaient lire des traits psychologiques dans les traits du visage. Aujourd’hui, chaque visage dans la rue porte un casier judiciaire, un nom, des relations, des opinions exprimées sur les réseaux sociaux, des habitudes de consommation, des engagements divers, et qui sait quoi d’autre encore.

Quand les inconnus qui vous croisent dans la rue peuvent accéder à des données sur vous par le simple fait que l’image de votre visage a été captée par des Google Glass, on amène la puissance coercitive du réseau jusque dans la rue. Sur le réseau, il est possible de prendre plusieurs identités. Mais nos prises de position politiques, notre réseau amical, notre réseau professionnel, notre CV, etc., se retrouvent, dans la rue, associés à un élément unique, visible, et facilement accessible à tous. Les créateurs des Google Glass ont fini par interdire cette possibilité, pour ne pas tuer leur création dans l’œuf. Si cette technique devenait courante, qui peut assurer que nous n’assisterons pas à l’avènement d’une époque qui supprimera totalement l’anonymat dans l’espace public ?

Une société de la défaite

Une anthropologue britannique, Sally A. Applin, a récemment publié un article très intéressant sur les dégâts sociaux causés, et surtout révélés, par la reconnaissance faciale (à lire ici, en anglais). Elle part de la question posée par un dirigeant d’entreprise américain sur Twitter : « Vivons-nous vraiment dans une société aussi dangereuse, pour avoir à ce point besoin de la reconnaissance faciale ? », et la précise : la reconnaissance faciale, pour quoi faire ?

Elle évoque bien sûr les intérêts industriels, et la facilité politique consistant à remplacer le personnel humain par des machines. Mais elle va plus loin : derrière le succès politique et médiatique de la technique à visée sécuritaire, elle voit la peur de l’autre. Le regard remplace la parole, et la distance remplace la rencontre. Même les agents de surveillance ne regardent plus les gens, mais des écrans. Ce qui devrait être un média est devenu une vitre isolante. C’est une logique de traitement des symptômes qui ne s’adresse jamais aux causes.

Elle remarque aussi que la « démocratisation » des caméras, maintenant que chacun porte sur soi un smartphone, a sans doute aussi contribué à leur banalisation, en faisant de chacun le surveillant potentiel de l’autre. C’était d’ailleurs l’idée principale de l’application « Reporty », retoquée à Nice par la CNIL au printemps 2018 : la mairie voulait lancer une application pour smartphone afin que les habitants signalent par vidéo les incivilités dont ils seraient témoins. Sally A. Applin souligne par ailleurs que l’accumulation de millions d’heures de vidéosurveillance que personne n’a le temps de regarder explique peut-être en partie l’enthousiasme des décideurs politiques pour la reconnaissance faciale automatisée : le fantasme de la surveillance totale est matériellement hors d’atteinte, sauf si l’humanité s’y consacre à temps plein, ou si elle délègue le travail à des machines (biaisées).

Est-ce vraiment le monde que nous voulons ? Cette société sans contact, cette société qui a peur de la parole et de l’engagement physique des uns avec les autres est une société déprimée, qui ne s’aime pas. Il est permis d’en vouloir une autre. Elle commence par interdire la reconnaissance faciale.

Source : La Quadrature du Net, 21-06-2019

Nous vous proposons cet article afin d'élargir votre champ de réflexion. Cela ne signifie pas forcément que nous approuvions la vision développée ici. Dans tous les cas, notre responsabilité s'arrête aux propos que nous reportons ici. [Lire plus]Nous ne sommes nullement engagés par les propos que l'auteur aurait pu tenir par ailleurs - et encore moins par ceux qu'il pourrait tenir dans le futur. Merci cependant de nous signaler par le formulaire de contact toute information concernant l'auteur qui pourrait nuire à sa réputation.

Commentaire recommandé

« Entre temps, elles auront supprimé un certain nombre de salarié·es. »

L’écriture « inclusive » (donc exclusive) est un bon moyen pour l’oligarchie de diviser les gueux en deux camps qui s’opposeront sur des pinailleries de ponctuation, au lieu de s’unir pour combattre les moyens techniques de surveillance généralisée.

43 réactions et commentaires

Réussir à sortir l’argument du racisme et du sexisme dans un article sur la reconnaissance faciale, il faut le faire : « le racisme et le sexisme de l’algorithme dérivent du racisme et du sexisme institués par la société, et consciemment ou inconsciemment. »

C’est calquer consciemment ou inconsciemment le dégoulinant discours ambiant qui pollue régulièrement le débat au lieu de partir du principe que les programmeurs, certainement blancs, ont commencé par le plus simple pour eux avant d’entendre la technologie à toute l’humanité. Que les femmes et les non blancs ne s’inquiètent pas, ils vont rapidement profiter des bienfaits, mais surtout des inconvénients de la technologie.

+21

AlerterRenseignez-vous, cette affirmation est AUTHENTIQUE.

Paru sur le site du MIT (pas particulièrement « complotiste »

https://www.media.mit.edu/articles/facial-recognition-technology-is-both-biased-and-understudied/

« The real-life consequences of biased algorithms: Undark on the racial problem of facial recognition tech, an issue that is the focus of Joy Buolamwini’s (Civic Media) TED Talk and her Algorithmic Justice League initiative. »

Et le lien sur l’étude (figurant sur le site du MIT) : https://undark.org/article/facial-recognition-technology-biased-understudied/

Si vous avez le temps, allez chercher sur les sites des universités US et vous serez effaré. C’est la raison pour laquelle l’état de Californie a strictement interdit l’utilisation de systèmes de reconnaissance faciale.

Comme les concepteurs de ces « systèmes » habitent dans cet état ils ne souhaitent pas être les victimes collatérales des bugs de leurs merdiciels.

Pas fous, même si ces dispositifs sont fortement rémunérateurs, il ne souhaitent pas se retrouvés fichés (ou truffés de plombs) par erreur suite à une erreur de LEURS systèmes les désignant comme membres d’organisations terroristes au premier carrefour.

+8

AlerterLe problème n’est pas de dénoncer un biais de l’algorithme, c’est de le mettre immédiatement sur le dos de programmeurs forcément blancs et racistes, alors que si ça se trouve les programmeurs sont à Shangaï, à Tokyo ou à Bangalore.

+13

AlerterJe ne rejette pas la responsabilité sur les grouillots qui pissent du code à longueur de journée, j’accuse preuves à l’appui les dirigeants et les propriétaires de ces entreprises de ne PAS réaliser des logiciels performants car leur seul objectif est simplement de fourguer des merdiciels à des crétins corrompus en faisant un maximum de profit.

Vous me répondrez que c’est TOUJOURS la même chose avec les marchés « publics » ou assimilés : Les « innovateurs » caressent le cul des décideurs, leur graissent la patte et fourguent une daube à un prix « défiant toute concurrence » (c’est la seule certitude que l’on puisse avoir) qui ne fonctionnera JAMAIS.

Regardez simplement d’autres « marchés publics » et vous serez con-vaincu : L’ANTS qui ne fonctionne pas depuis Narközy (avec une seconde couche Hollande), Louvois qui ne paye pas les soldes des militaires, etc, etc…

Si ces entreprises vendaient directement au public elles auraient coulé depuis longtemps avec tous les procès qui leur seraient intentés et qu’ils perdraient à longueur de journée.

Par contre, pour les marchés « publics » (quelque soit l’état), ils ne sont JAMAIS poursuivis car les « décideurs » considèrent que les dysfonctionnements sont causés par ces abrutis d’utilisateurs qui n’ont pas compris la grandeur de cette innovation.

+0

Alerterc’est aussi partiellement faux : algorithmes auto-apprenant, ce n’est pas le developpeur qu’il faut incriminer, mais effectivement les comportements que « l’algorithme » s’échine à reproduire, desquels il « apprend ».

cela pose plus généralement la question du contrôle de ces modèles, et c’est plutôt donc un mélange des syndromes de la boîte noire, et de l’apprenti sorcier…

+7

AlerterLes algo auto-apprenant se bases sur des jeux de données pour apprendre. Les biais du jeu de données (un ensemble de photo de visage par exemple, ne sera certainement pas le même s’il est préparé à Tokyo, New-York ou Nairobi) se retrouveront donc dans le résultat de l’apprentissage et, auto-apprentissage oblige, on ne saura même pas pourquoi a priori. Pas vraiment mieux. Mais quoi qu’il en soit, les biais existent toujours.

+2

AlerterEst-ce que les algorithmes auto-apprenent vraiment ? Si vous utilisez le terme « auto » dans le sens « autonome », je reste dubitatif. Si j’ai bien compris, les algo « apprennent » uniquement des données qu’un humain veut bien leurs fournir. Si les données sont biaisées, les résultats seront également biaisés.

Sinon, comment vous appelez les gens qui développent les modèles ?

+1

Alerteravec le système de facebook qui se nourrit des photos uploadées et des précisions que les utilisateurs apportent de bonne volontés, le système peut très probablement être considéré comme auto apprenant. On peut même subodorer qu’il s’auto évalue. De là à dire qu’il s’auto morphe pour changer son modèle au gré de ces évaluations, je ne sais pas. Mais bon j’ai envi de dire que ce n’est qu’une question de temps de travail et de ressources. La volonté de faire naître skynet étant elle, tout à fait réel, bien que la dynamique de cette volonté reste mystérieuse.

Sinon quand un économiste se réveillera pour rappeler qu’a remplacer tout travail humain par du travail machine, en dehors des considérations sur l’usage de ressources et la pollution corollaire, détruit ispo facto le système économique basé sur l’échange des agents, je veux bien qu’on me réveil… Autrement il faudra considérer qu’ils travailent à la transformation du système actuel basé sur des agents humains vers un système basé sur des agents robotique afin que quelque chose de stable puisse permettre aux derniers possédants de régner sur terre dans un simulacre de vie assistée par ordinateur.

+2

AlerterLe « deep learning » (ou plutôt les algos qui le gèrent) sont écrits pour optimiser l’apprentissage dans un cas particulier.

Si on essaye « d’apprendre » autre chose de radicalement différent les résultats peuvent s’avérer désastreux.

Exemple : Les « IA » de jeu d’échec. L’ago d’auto-apprentissage est optimisé pour jouer aux échecs et si on tente de lui apprendre la belote il sera complètement « aux fraises ».

Alors quand on demande à un tel algo de faire de la reconnaissance faciale il ne faut pas s’étonner qu’il confonde la reine blanche avec un fou noir.

Surtout si on l’a entraîné avec des pions et des cavaliers blancs.

Quand de plus ces algos ont été écrits par tâtonnements successifs sans parfaitement savoir ce qui se passe réellement lors de l’estimation du résultat, ça s’apparente plus à de la cartomancie ou du « paranormal » avec une boule de cristal ou un pendule.

Tant que les scientifiques (sérieux) ne sauront pas comment fonctionne UN SEUL neurone et qu’ils ne sauront pas NON PLUS comment fonctionnent plusieurs neurones interconnectés il sera totalement illusoire de tenter de s’approcher de « l’intelligence » d’une simple bactérie ou d’une paramécie (unicellulaires dépourvus de neurones).

Quant à Caenorhabditis elegans, petit ver nématode doté de 302 neurones il est totalement impossible de s’approcher des performances de cet animal (qui survit depuis des millions d’années) même avec des calculateurs qui consomment des centaines de KW.

Une guêpe possède moins d’un million de neurones et elle est capable de reconnaître visuellement sans erreur ses propres congénères.

En ne consommant que quelques picowatts en plus.

LA solution consisterait à greffer des cerveaux de guêpes dans les caméras de reconnaissance faciale, ce serait bien plus fiable que ces algos qui fonctionnent par « l’opération du Saint Esprit ».

+3

AlerterEffectivement, selon l’article, les développeurs sont « des hommes blancs », donc c’est leur « racisme » qui s’exprime dans les biais de reconnaissance.

Tout d’abord, « l’effet de race » en reconnaissance faciale entre individus est un phénomène connu et considéré comme naturel (du moins dans cet extrait de thèse: http://theses.univ-lyon2.fr/documents/getpart.php?id=lyon2.2001.baudouin_jy&part=37455). Y projeter du racisme, qui dans sa définition habituelle est une idéologie, est au pire une imposture, au mieux un stéréotype.

Ensuite, pour les développeurs « hommes blancs », je ne sais pas d’où l’auteur sort cette information. En googlant 5 minutes (et je doute que l’auteur de l’article l’ait fait), on trouve que le logiciel utilisé au Pays de Galles est développé par une multinationale… japonaise: NEC (https://www.ft.com/content/06c46942-cc7d-11e8-b276-b9069bde0956), mais ça ne veut pas dire que les développeurs sont forcément japonais (ou asiatiques, ou blancs…). L’article de Big Brother Watch auquel la Quadrature du Net se réfère est d’ailleurs un peu plus mesuré dans sa description du problème.

Finalement, pour les critères de reconnaissance faciale du tramway de Nice, « Avoir un type maghrébin et un sweat à capuche entre sûrement dans les critères. Mais quoi d’autre ? » Cette affirmation a-t-elle une source autre que l’amalgame « police + sud-est = racistes »?

Faire preuve de tant de biais dans un article qui prétend justement dénoncer celui des systèmes de reconnaissance faciale dessert totalement un document sinon rempli d’informations intéressantes.

+8

Alerter> selon l’article, les développeurs sont “des hommes blancs”

Selon mon expérience personnelle (qui n’a aucune valeur statistique), les développeurs en IA sont principalement indiens.

+6

AlerterLes « modèles » qui servent à « gaver » les algos de « deep learning » sont de « caucasiens » pour une raison très simple : Les seuls qui ont les moyens d’acquérir ces merdiciels (et qui sont assez cons pour le faire) sont occidentaux.

Donc il est idiot d’alimenter ces algos avec des images de personnes qui ne correspondent pas au « marché cible ».

Par contre, ça montre AUSSI que ces algos sont franchement pourris car ils sont incapables de différencier des « objets » dont seule la couleur change.

Ceux qui prônent ces « avancées technologiques » nous prennent VRAIMENT pour des jambons (ou des tanches si votre religion vous interdit de manger du porc).

D’un côté nous avons des « serviteurs de l’état » qui souhaitent conserver leur place et sauver leurs fesses joufflues de la colère populaire, et de l’autre nous avons de « géniaux entrepreneurs » qui voient là une opportunité d’accumuler les profits sans trop se fatiguer.

Ils étaient réellement faits pour s’entendre. Le seul problème c’est que ce sont les « imbéciles » comme vous et moi qui payons la facture pour ces instruments foireux destinés à nous mener vers une dictature « décomplexée ».

Et que les systèmes soient « optimisés » pour reconnaître exclusivement les visages de caucasiens devrait AUSSI vous inquiéter. S’ils étaient adaptés à la reconnaissance unique de visages asiatiques les « grands humanistes » se mettraient à hululer en prétendant que les dictateurs chinois veulent fliquer leur population.

Oups, c’est déjà fait…

Mais motus pour les « grandes démocraties occidentales ».

+1

AlerterVotre remarque, bien que pertinente, suggère qu’a terme les algorithmes seront nécessairement non biaisés culturellement et/ou socialement… c’est trivialement faux à moins de postuler l’existence d’une objectivité universelle. Quelques lectures sur les résultats actuels en AI vous l’expliqueront dans le détail.

+3

Alerter> Devra-t-on bientôt faire ses courses avec un sac sur la tête ?

Je pense que si je fais cela aujourd’hui même, le vigile ne me laissera pas entrer, et d’une manière générale, la populace aura tôt fait d’en appeler à la police au prétexte d’un dangereux terroriste. Policiers qui auront le zèle, je n’en doute pas, de me laisser pourrir en cellule aussi longtemps que possible.

Mais pour le fun, il se pourrait que je le tente sérieusement.

De cette absurdité exposée on se rend compte que le consentement ça fait longtemps qu’on s’en contre balance au nom de la sécurité.

+5

AlerterLes prisonniers travaillent déjà… Il y a une telle méconnaissance de la Zonzon dans ce pays…

+6

Alerter« Entre temps, elles auront supprimé un certain nombre de salarié·es. »

L’écriture « inclusive » (donc exclusive) est un bon moyen pour l’oligarchie de diviser les gueux en deux camps qui s’opposeront sur des pinailleries de ponctuation, au lieu de s’unir pour combattre les moyens techniques de surveillance généralisée.

+29

AlerterL’écriture inclusive vise à mettre à égalité les deux « camps » que vous évoqué… je ne vois pas bien le lien avec l’oligarchie ici.

Vous être sans doute comme moi dans le camp des mâles et bizarrement ça vous semble équitable que le masculin l’emporte… mais peut-être que l’autre « camp » n’est pas d’accord, et ça n’a aucun rapport avec l’oligarchie.

+4

AlerterMathieu, « le masculin l’emporte » est un « concept » dont on s’est passé pendant des années. Et tant mieux, je suis une femme, une simple femelle puisque vous parlez de mâles, donc je ne suis pas dans « le camp des mâles ». Pour ma part, je pense qu’il y a bien d’autres injustices plus graves que les régles d’orthographe à l’égard aussi bien de millions d’enfants, millions de femmes et d’hommes sur cette planète. Ce n’est pas en défigurant notre langue écrite qu’on réglera ces problèmes PRIMORDIAUX.

+16

AlerterOui mais l’écriture inclusive ne règle pas le problème du tout.

Et au lieu de régler le problème, elle introduit une autre différenciation, entre ceux qui l’utilisent et ceux qui ne l’utilisent pas (hommes ou femmes, peu importe).

+7

AlerterRapporter le genre des mots au sexe des humains est très stupide, mais pour ceux qui voudraient mener leur héroïque combat dans cette logique il devrait être plus important de revendiquer qu’on dise et écrive, par exemple, « un couille » et « une vagin », non?

+3

AlerterVous écoutez trop les sketches de Roland Magdane.

Dans son sketch il mentionne aussi LA moustache, LE rouge à lèvres etc…

S’étriper pour des questions de « genre » des mots est un moyen utile de détourner l’attention d’autres problèmes bien plus importants.

Un ami d’enfance est « homo » (plus franchement jeune maintenant) et il se mettait en colère quand il voyait tous ces idiots qui, selon son expression, « foutaient le bordel avec leurs conneries ».

Et ses amis (de même « confession » – que j’apprécie beaucoup car ils sont intelligents, sympas et ne font pas de prosélytisme) étaient aussi passablement « énervés » par ces « petits cons » (selon leur expression) qui montaient la population contre eux par simple réaction.

Tout ce qu’ils voulaient, c’est qu’on leur FOUTE LA PAIX et qu’on les laisse vivre comme ils le veulent.

À mon avis, c’est pas gagné…

Avec les grandes manifs LGBT et tous les excès destinés à CHOQUER la population, sans compter la propagande nauséabonde de la « théorie du genre » (qui n’est PAS une théorie, juste un délire fumeux repris par les politiques pour diviser la population) on vient ensuite s’étonner parce qu’un trans s’est fait agresser à récemment Grenoble…

Ce que j’apprécie le plus chez les « VRAIES » personnes « différentes », c’est qu’elles me respectent et me foutent une paix royale sans vouloir me « convertir » ou m’imposer leur point de vue.

Et je leur rends leur politesse en les laissant vivre leur vie comme elles l’entendent dans le plus grand respect.

Par contre, si une personne, quelque soit sa « tendance » sentimentale, religieuse ou politique, vient me chercher des poux, elle sera reçue avec tous les « égards » qui lui sont dus.

+7

AlerterOn pourrait aussi parler d’écriture « sexiste » et « ségrégationniste ». Cela dit, c’est la suite logique de la féminisation des noms de professions et de statuts sociaux… Si cela devient vraiment trop insupportable, vous pouvez chercher le texte dans la langue de Shakespeare. A ma connaissance, l’anglais ne s’embarrasse pas avec cette « subtilité » langagière, so « frenchie ».

+1

AlerterReconnaissance faciale, « Intelligence artificielle », sont en fait des dénominations ronflantes de techniques et de systèmes BREVETÉS dont la fiabilité et l’utilité sont franchement douteuses mais qui par contre génèrent des profits faramineux pour les entreprises qui les exploitent.

Outre les nombreux biais de la reconnaissance faciale (avec entre autres les biais concernant le sexisme et la couleur de peau) il ne faut surtout pas oublier que ces dispositifs sont encore à l’état de prototypes et qu’ils le resteront encore bien longtemps car on ne sait pas encore comment fonctionne le système de reconnaissance des animaux les plus simples (avec très peu de neurones et peu d’énergie consommée – mais qui fonctionne réellement lui).

Quant à la « fabuleuse » IA, c’est aussi un bel exemple de buzz technico-commercial dont le seul objectif et de rapporter des profits juteux à ceux qui les commercialisent.

Tous ces systèmes, comme TOUS les produits industriels, sont en fait « optimisés » pour que leur conception et leur fabrication soient les moins coûteux possibles et de très nombreuses approximations et impasses sont faites pour maximiser les profits, comme pour un simple téléphone, une casserole ou une automobile.

Et ensuite, entre marketing et lobbying bien plus coûteux que le développement de ces produits, ces « entrepreneurs » parviennent à fourguer leurs merdes comme s’il s’agissait de simple lessive.

Business first, même si c’est de la merde au moins ça fait « tourner l’économie ».

+5

AlerterEtat de prototype..;ils sont utilisés maintenant en production dans les aéroports, les gares, les places publiques, les écoles et le pays le plus avancé dans ce domaine n’est pas la Chine mais la Grande-Bretagne. La notion de coût unitaire n’existe pas car les logiciels sont centralisés ainsi que les bases de reconnaissance, les capteurs locaux et les caméras ont des coûts unitaires déja très bas.

Pour les programmeurs la majorité sont à Bangalore en Inde et maintenant de plus en plus au Vietnam pas beaucoup de blancs à ces endroits. En plus ils sont vraiment très bons..;et 3 a 4 fois moins cher qu’un ingénieur texan ou californien..

L’IA n’est pas un ensemble de buz…mais se trouve a la pointe en ce qui concerne les algos et les organisations de meta-données. Préférable d’avoir un doctorat dans ce domaine pas de places pour les bidouilleurs.

Je serais curieux de savoir d’ou vous tenez ces chiffres sur les coûts du marketing et du lobbying. Quelles sont vos sources ? En général en informatique ce sont des coûts très bas par rapport aux sommes consacreés au développement et a la maintenance.

+3

Alerter« Big brother is watching you »

Bienvenue dans le meilleur des mondes Orwellien de la démocratie représentative (oxymore), du politiquement correcte, de la propagande médiatique et de la chasse aux GJ, ces gueux qui refusent de courber l’échine….

+12

AlerterCasquette, sweat à capuche et lunettes de soleil… et je suis invisible 😊

+2

AlerterEn fait, le suivi par le téléphone portable est plus efficace (pas seulement grâce aux antennres téléphoniques, mais aussi par GPS, Wifi, Bluetooth, RFID, caméra, micro). Mais la police peut prétendre faire un suivi par reconnaissance faciale afin que les citoyens à surveiller se concentrent sur leur déguisement au lieu d’éteindre leur téléphone.

+11

Alerternon, ce genre d’accoutrement ne passe pas inaperçu partout.

En revanche mon apparence me rend réellement invisible aux yeux des gens, mais c’est malgré ma volonté. Ce n’est que très exceptionnel qu’un vigile de supermarché m’a demandé à vérifier mon sac à dos qui me sert à porter mes courses, alors que les jeunes se font systématiquement contrôler quelle que soit la couleur de leur peau ou leur look.

+0

AlerterEn Grande-Bretagne, où la surveillance vidéo est omniprésente, les centres commerciaux interdisent le port du sweat à capuche…

+3

AlerterTrès bon article, merci. Quelle est l’utilité sociale de la reconnaissance faciale généralisée dans l’espace public? Pouvoir attribuer un score social? On ne traverse pas dans les clous: plus d’allocs, d’avancement ou de crédits? Ou même une rétrogradation professionnelle? La Chine y va tout droit, souhaitons nous la même chose? Il me semble qu’il est plutôt temps de remettre de l’humain dans le lien social…

+3

Alerteril est plus que temps d’admettre que le modèle chinois est le nouvel eldorado des gouvernants de tous poils de tous les pays du monde. Notre volonté, au sens populaire du terme, n’existe plus, et ce n’est pas le mantra des gauchistes à prétendre que les GJ ont obtenu quelque chose qui me fera changer d’avis la dessus.

+2

AlerterA part la reconnaissance faciale , j’ai rencontré un scientifique ( je ne dirai pas de quelle nationalité ) qui bossait sur la » reconnaissance émotionnelle » .. la prochaine fois que vous faites un retrait à votre banque vaut mieux être très zen ..

Certaines recherches portent sur la lecture des pensées , qui devraient je pense aboutir bientôt , quand on aura mieux compris certains mécanismes cérébraux .

En intelligence artificielle ils travaillent sur des implants cérébraux destinés à fournir à l’heureux détenteur dudit des tonnes de données dépassant la mémoire humaine normale , et l’accès instantané à des apprentissages comme par exemple le pilotage d’avions .

+1

Alerter« maintenant que chacun porte sur soi un smartphone » donc on est déviant si on n’a en a pas ?

+7

Alerteril est plus intéressant de noter que cette déviance est mue par le besoin du groupe social de conforter ses choix dans le comportement de l’autre. Le groupe social tend à l’uniformisation de ses participants. La déviance que vous feintez de découvrir est plus la marque de l’esprit fasciste globalisé de l’homme moderne ultra connecté d’un bout à l’autre de la planète qu’une véritable marque de différenciation.

que l’état se serve de ce menu détail pour vous catégoriser et vous potentialiser n’est encore une fois que la marque de son esprit étriqué au service de son désir de pouvoir et de contrôle (pour ne pas utiliser 15 fois le même mot commençant par un f). L’état se fou de cette différence tant qu’elle ne sert pas ses intérêts.

+0

Alerter“qui peut assurer que nous n’assisterons pas à l’avènement d’une époque qui supprimera totalement l’anonymat dans l’espace public ?”

La mode des sweatshirts à capuche s’est d’abord répandue chez les jeunes noirs new-yorkais qui ne voulaient pas être reconnus lorsqu’ils étaient filmés par les caméras de vidéosurveillance, avant de se répandre sur toute la planète.

Je suis prêt à parier que si l’anonymat disparaît de l’espace public, ça deviendra à la mode de porter de grosses lunettes de clown, des chapeaux ou des bonnets couvrant les oreilles, et des écharpes dissimulant le bas du visage (ou des masques anti-pollution, comme au Japon), et les femmes se voileront le visage, comme des musulmanes. Les autorités ne pourront rien y faire parce que ce sera un phénomène massif.

+1

AlerterIl me semble qu’en France il n’est plus permis de se déguiser en cachant son visage dans les manifestations. Intox ou pas ?

+3

Alerterc’est tout le visage et partout dans l’espace public qu’il est interdit de cacher son visage :

Loi interdisant la dissimulation du visage dans l’espace public

https://fr.wikipedia.org/wiki/Loi_interdisant_la_dissimulation_du_visage_dans_l%27espace_public

+4

AlerterDepuis le 1er janvier 2014, les fonctionnaires de police sont tenus de porter un numéro à 7 chiffres, qui permet de les identifier le RIO.

+2

AlerterSans doute la plus grosse erreur a été d’arrêter l’expérience de Police de proximité (Sarkozy – 2003). Il est étrangement impossible de trouver un bilan concret de cette expérience.

Des policiers plus présents, mais plus « civils » et plus humains est une solution qui me conviendrait mieux que Robocop (Edward Neumeier, scénariste du film, encore américain tristement visionnaire)

+6

AlerterIl serait intéressant aussi de voir que la vision utilitariste (Bentham et Hobbes) et pourquoi autrement que pour faire du fric cette philosophie domine la vision de ce monde des société de la Silicon Valley : Panoptique + Leviathan = contrôle social ?

Trouvé sur Wikipedia – article panoptique :

« La morale réformée, la santé préservée, l’industrie revigorée, l’instruction diffusée, les charges publiques allégées, l’économie fortifiée — le nœud gordien des lois sur les pauvres non pas tranché, mais dénoué — tout cela par une simple idée architecturale. »

— Jeremy Bentham, Le Panoptique, 1780 (l’ouvrage, de 56 pages, est traduit de l’anglais et imprimé par ordre de l’Assemblée législative en 1791)

+0

AlerterLa Chine est le laboratoire expérimental de ce qui attend le reste du monde, et ce monde hélas le demandera sous couvert de sécurité.

+0

AlerterEn lisant les commentaire je me rends vraiment compte de l’absolue nescessité de démystifier ces termes « intelligence artificielle » « algorithme » etc. Tout ceci regroupe en réalité des choses très différentes. J’ajoute que la machine – même si elle est dite « intelligente » fait bêtement ce pour quoi on l’a conçue.

Je recommande vivement cette interview de Luc Julia un des créateurs de Siri :

https://www.journaldugeek.com/dossier/lintelligence-artificielle-nexiste-interview-de-luc-julia-cocreateur-de-siri/

Dites-vous bien que à chaque fois qu’on parle d’IA on parle d’une ingénierie faite par des vrais gens qui cherchent a atteindre un vrai objectif (économique ou politique). Il ne faut pas perdre de vue que – bien qu’ils soient présentés comme des systèmes de protection ou de communication avec ses amis – ce sont des systèmes espions qui ont étés conçus comme tels par des gens qui ont déjà beaucoup de pouvoir et veulent tout savoir sur nos vies et ça c’est vraiment très dangereux.

Ce genre de système devrait être administré démocratiquement pour pouvoir entrer dans l’espace public, on devrait refuser catégoriquement ces dispositifs de serveillance de la population tant qu’il ne seront pas régulés et contrôlés par des citoyens (par exemple sur le modèle des contre-pouvoirs chers a Montesquieu) Certainement pas laisser carte blanche aux grandes firmes ou aux politiciens) comme nous sommes en train de le faire. C’est la porte ouverte au totalitarisme et je crains qu’on y est déjà..

+0

AlerterCet article ne parle pas du « paradis » de la videosurveillance qu’est la Chine. Les algorithmes y sont bien meilleurs et fonctionnent bien mieux. Le volume d information et la base de donnée constitué y est bien plus large; son utilisation bien plus étendue. Article très intéressant sur les questions posés etc. Mais d’un point de vue des sources cités et le point sur la réalité de la technologie etc. On a l’impression de voir un article sur la conquête spatiale qui ne prendrai en compte que la situation du continent africain.

Merci a l’auteur, hormis ce biais qui inflechis la position de l’article sur la réalité de cette technologie, celui-ci est assez détaillé.

+0

AlerterLes commentaires sont fermés.