Les systèmes d’armes autonomes mortels et la lutte pour les contrôler.

Source : Common Dreams, Rebecca Gordon

Traduit par les lecteurs du site Les-Crises

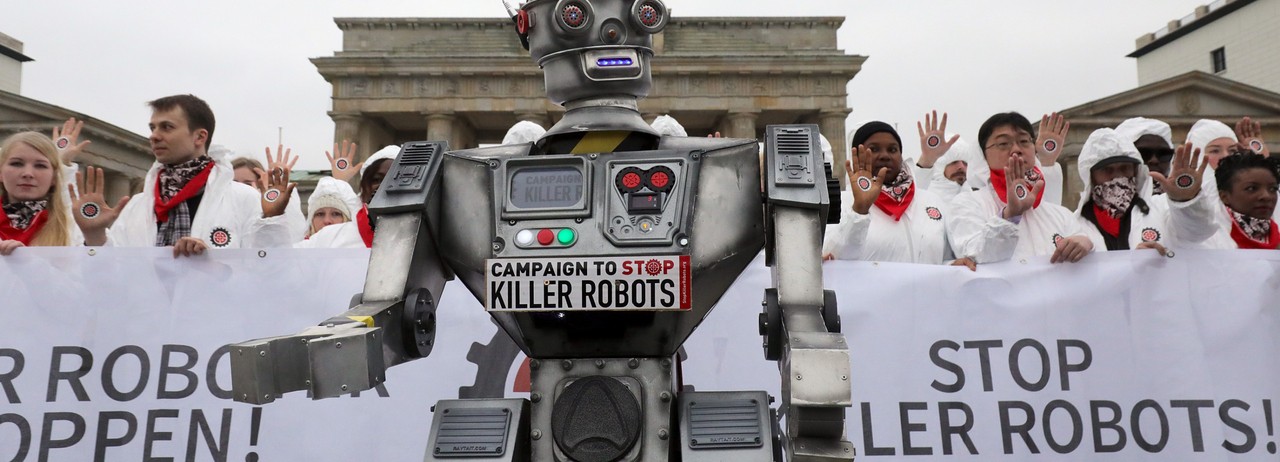

Des personnes participent à une manifestation « Stop Killer Robots » le 21 mars 2019 à Berlin. (Photo : Wolfgang Kumm/DPA/AFP via Getty Images)

Voici un scénario à envisager : une force militaire a acheté un million de drones volants bon marché et jetables, chacun de la taille d’un jeu de cartes, capable de transporter trois grammes d’explosifs – assez pour tuer une seule personne ou, dans une « charge creuse », percer un mur d’acier. Ils ont été programmés pour rechercher et « engager » (tuer) certains êtres humains, sur la base de caractéristiques spécifiques de « signature » comme le port d’une arme, par exemple, ou une couleur de peau particulière. Ils tiennent dans un seul conteneur d’expédition et peuvent être déployés à distance. Une fois lancés, ils volent et tuent de manière autonome sans aucune autre action humaine.

De la science-fiction ? Pas vraiment. Cela pourrait arriver demain. La technologie existe déjà.

En fait, les systèmes d’armes autonomes létaux (LAWS, pour Lethal Autonomous Weapons Systems) ont une longue histoire. Au printemps 1972, j’ai passé quelques jours à occuper le bâtiment de physique de l’université Columbia à New York. Avec une centaine d’autres étudiants, j’ai dormi sur le sol, mangé des plats à emporter et écouté Alan Ginsberg lorsqu’il est venu nous honorer de quelques-uns de ses poèmes improvisés. J’écrivais alors des tracts, réquisitionnant une machine Xerox pour les imprimer.

Et pourquoi, parmi tous les bâtiments du campus, avons-nous choisi celui qui abrite le département de physique ? La réponse : pour convaincre cinq physiciens de la faculté de Columbia de rompre leurs liens avec le Jason Defense Advisory Group du Pentagone, un programme offrant de l’argent et des laboratoires pour soutenir la recherche scientifique fondamentale qui pourrait s’avérer utile aux efforts de guerre des États-Unis. Notre objection spécifique : l’implication des scientifiques de Jason dans la conception de certaines parties de ce qui était alors connu sous le nom de « champ de bataille automatisé » pour un déploiement au Vietnam. Ce système s’avérerait en effet être un précurseur des systèmes d’armes autonomes létales qui sont sur le point de devenir une partie potentiellement significative de l’arsenal de ce pays et du monde entier.

Les premières armes (semi-)autonomes

Washington était confronté à un certain nombre de problèmes stratégiques en poursuivant sa guerre en Indochine, notamment la corruption générale et l’impopularité du régime sud-vietnamien qu’il soutenait. Cependant, son plus grand défi militaire était probablement l’infiltration continue de personnel et de fournitures par le Nord-Vietnam sur ce qu’on appelait la piste Ho Chi Minh, qui courait du nord au sud le long des frontières cambodgienne et laotienne. La Piste était en fait un réseau de routes et de chemins de terre facilement réparables, de ruisseaux et de rivières, situés sous une épaisse couverture de jungle qui rendait presque impossible la détection des mouvements depuis les airs.

La réponse américaine, développée par Jason en 1966 et déployée l’année suivante, était une tentative d’interdire cette infiltration en créant un champ de bataille automatisé composé de quatre parties, analogues aux yeux, aux nerfs, au cerveau et aux membres d’un corps humain. Les yeux étaient constitués d’une grande variété de capteurs – acoustiques, sismiques et même chimiques (pour détecter l’urine humaine) – le plus souvent largués par voie aérienne dans la jungle. Les équivalents nerveux transmettaient des signaux au « cerveau ». Cependant, comme les capteurs n’avaient qu’une portée maximale d’environ 30 km, l’armée américaine devait constamment faire voler des avions au-dessus du couvert forestier pour capter tout signal susceptible d’être déclenché par le passage de troupes ou de transports nord-vietnamiens. Les avions devaient ensuite relayer les nouvelles au cerveau. (Conçus à l’origine pour être télécommandés, ces avions avaient des performances si médiocres que des pilotes humains étaient généralement nécessaires).

Et ce cerveau, une magnifique installation militaire construite en secret à Nakhon Phanom, en Thaïlande, abritait deux ordinateurs centraux IBM à la pointe de la technologie. Une petite armée de programmeurs écrivait et réécrivait le code pour les faire fonctionner, tout en essayant de donner un sens au flux de données transmises par ces avions. Les coordonnées des cibles qu’ils obtenaient étaient ensuite transmises aux avions d’attaque, qui étaient les équivalents des membres. Le groupe qui dirigeait ce champ de bataille automatisé était appelé Task Force Alpha et l’ensemble du projet portait le nom de code Igloo White.

Il s’est avéré que l’Igloo White a été en grande partie un échec coûteux, coûtant environ un milliard de dollars par an pendant cinq ans (un total de près de 40 milliards de dollars en dollars d’aujourd’hui). Le décalage entre le déclenchement d’un capteur et le largage des munitions a rendu le système inefficace. Par conséquent, la Task Force Alpha a parfois simplement bombardé des zones où un seul capteur aurait pu se déclencher. Les Nord-Vietnamiens ont rapidement compris le fonctionnement de ces capteurs et ont mis au point des méthodes pour les tromper, allant de la diffusion d’enregistrements de démarrage de camions à la mise en place de seaux d’urine.

Étant donné l’histoire des systèmes d’armes semi-automatisés tels que les drones et les « bombes intelligentes » dans les années qui ont suivi, vous ne serez probablement pas surpris d’apprendre que ce premier champ de bataille automatisé ne pouvait pas faire la distinction entre les soldats et les civils. En cela, ils n’ont fait que poursuivre une tendance qui existe depuis au moins le XVIIIe siècle et selon laquelle les guerres tuent régulièrement plus de civils que de combattants.

Aucune de ces lacunes n’a empêché les responsables du ministère de la Défense de considérer le champ de bataille automatisé avec admiration. Andrew Cockburn a décrit cette attitude d’adoration dans son livre Kill Chain : The Rise of the High-Tech Assassins [La chaîne d’assassinat : la montée en puissance des assassins high-tech, NdT], citant Leonard Sullivan, un haut fonctionnaire du Pentagone qui a visité le Vietnam en 1968 : « Tout comme il est presque impossible d’être agnostique dans la cathédrale de Notre-Dame, il est difficile de ne pas se laisser emporter par la beauté et la majesté du temple de la Task Force Alpha. »

Qui ou quoi, vous pouvez vous le demander, devait être vénéré dans un tel temple ?

La plupart des aspects de ce champ de bataille « automatisé » de l’ère du Vietnam nécessitaient en fait une intervention humaine. Des êtres humains installaient les capteurs, programmaient les ordinateurs, pilotaient les avions et lâchaient les bombes. Dans quel sens, alors, ce champ de bataille était-il « automatisé » ? Comme un signe avant-coureur de ce qui allait arriver, le système avait éliminé l’intervention humaine à un seul point crucial du processus : la décision de tuer. Sur ce champ de bataille automatisé, les ordinateurs décidaient où et quand larguer les bombes.

En 1969, le chef d’état-major de l’armée William Westmoreland a exprimé son enthousiasme pour l’élimination de l’élément humain désordonné de l’élaboration de la guerre. S’adressant à un déjeuner de l’Association de l’US Army, un groupe de pression, il a déclaré :

« Sur le champ de bataille du futur, les forces ennemies seront localisées, suivies et ciblées presque instantanément grâce à l’utilisation de liaisons de données, à l’évaluation du renseignement assistée par ordinateur et à la conduite de tir automatisée. Avec des probabilités d’élimination au premier tour proches de la certitude, et avec des dispositifs de surveillance capables de suivre l’ennemi en permanence, la nécessité de disposer de forces importantes pour fixer l’opposition sera moins importante. »

Ce que Westmoreland voulait dire par « fixer l’opposition », c’était tuer l’ennemi. Un autre euphémisme militaire du XXIe siècle est « engager ». Dans les deux cas, le sens est le même : le rôle des systèmes d’armes autonomes létaux est de trouver et de tuer automatiquement des êtres humains, sans intervention humaine.

De nouvelles LAWS pour une nouvelle ère – Les systèmes d’armes autonomes létaux

Chaque automne, la British Broadcasting Corporation parraine une série de quatre conférences données par un expert dans un domaine d’étude important. En 2021, la BBC a invité Stuart Russell, professeur d’informatique et fondateur du Center for Human-Compatible Artificial Intelligence de l’université de Californie à Berkeley, à donner ces « conférences Reith ». Son sujet général était l’avenir de l’intelligence artificielle (IA), et la deuxième conférence était intitulée « Le rôle futur de l’IA dans la guerre ». Il y abordait la question des systèmes d’armes autonomes létaux, ou LAWS, que les Nations unies définissent comme « des armes qui localisent, sélectionnent et engagent des cibles humaines sans supervision humaine. »

Le point principal de Russell, éloquemment exposé, est que, bien que de nombreuses personnes pensent que les armes autonomes létales sont un futur cauchemar potentiel, résidant dans le domaine de la science-fiction, « elles ne le sont pas. Vous pouvez les acheter aujourd’hui. Elles sont proposées sur le web. »

Je n’ai jamais vu aucun des films de la franchise Terminator, mais apparemment les planificateurs militaires et leurs chargés de relations publiques supposent que la plupart des gens tirent leur compréhension de ces LAWS de ce monde dystopique fictif. Les responsables du Pentagone ont souvent du mal à expliquer pourquoi les armes qu’ils développent ne sont pas, en fait, des équivalents réels de SkyNet – le réseau mondial de communication qui, dans ces films, prend conscience de lui-même et décide d’éliminer l’humanité. Ne vous inquiétez pas, comme l’a déclaré à Russell un secrétaire adjoint à la Défense : « Nous avons écouté attentivement ces arguments et mes experts m’ont assuré qu’il n’y a aucun risque de créer accidentellement SkyNet. »

L’argument de Russell, cependant, était qu’un système d’armes n’a pas besoin d’être conscient de lui-même pour agir de manière autonome ou pour présenter une menace pour des êtres humains innocents. Ce dont il a besoin, c’est :

- Une plateforme mobile (tout ce qui peut se déplacer, du minuscule quadricoptère à un avion à voilure fixe).

- Une capacité sensorielle (la capacité de détecter des informations visuelles ou sonores).

- La capacité de prendre des décisions tactiques (le même type de capacité que l’on trouve déjà dans les programmes informatiques qui jouent aux échecs).

- La capacité « d’engager », c’est-à-dire de tuer (ce qui peut être aussi compliqué que de tirer un missile ou de larguer une bombe, ou aussi rudimentaire que de commettre un suicide robotique en percutant une cible et en explosant).

La réalité est que de tels systèmes existent déjà. En effet, une entreprise d’armement publique turque a récemment fait la publicité de son drone Kargu, un quadricoptère « de la taille d’une assiette », comme l’a décrit Russell, qui peut transporter un kilogramme d’explosifs et est capable d’effectuer des « frappes autonomes antipersonnel » avec des « cibles sélectionnées sur des images et par reconnaissance faciale ». Le site de la société a depuis été modifié pour souligner son adhésion à un supposé principe de « l’être humain dans la boucle ». Cependant, l’ONU a signalé qu’un Kargu-2 entièrement autonome a, en fait, été déployé en Libye en 2020.

Vous pouvez dès à présent acheter votre propre quadricoptère sur Amazon, mais vous devrez tout de même mettre en œuvre quelques compétences informatiques de bricolage si vous voulez qu’il fonctionne de manière autonome.

En réalité, les systèmes d’armes autonomes mortels ont moins de chances de ressembler à un film de Terminator qu’à des essaims de minuscules robots tueurs. La miniaturisation des ordinateurs signifie que la technologie existe déjà pour créer des LAWS efficaces. Si votre téléphone intelligent pouvait voler, il pourrait être une arme autonome. Les téléphones les plus récents utilisent un logiciel de reconnaissance faciale pour « décider » d’autoriser l’accès. Il n’est pas difficile de créer des armes volantes de la taille d’un téléphone, programmées pour « décider » d’attaquer des individus spécifiques, ou des individus présentant des caractéristiques spécifiques. En fait, il est probable que de telles armes existent déjà.

Peut-on rendre les LAWS illégales ?

Alors, qu’est-ce qui ne va pas avec les LAWS, et y a-t-il un intérêt à essayer de les rendre illégales ? Certains opposants affirment que le problème est qu’ils éliminent la responsabilité humaine dans la prise de décisions létales. Ces critiques suggèrent que, contrairement à un être humain qui vise et appuie sur la gâchette d’un fusil, une LAWS peut choisir et tirer sur ses propres cibles. C’est là, selon eux, que réside le danger particulier de ces systèmes, qui feront inévitablement des erreurs, comme le reconnaîtra toute personne dont l’iPhone a refusé de reconnaître son visage.

À mon avis, le problème n’est pas que les systèmes autonomes écartent les êtres humains des décisions létales. Dans la mesure où les armes de ce type font des erreurs, les êtres humains porteront toujours la responsabilité morale du déploiement de ces systèmes létaux imparfaits. Les LAWS sont conçus et déployés par des êtres humains, qui restent donc responsables de leurs actions. Comme les drones semi-autonomes du moment (souvent pilotés depuis l’autre bout du monde), les systèmes d’armes autonomes létaux ne suppriment pas la responsabilité morale humaine. Ils augmentent simplement la distance entre le tueur et la cible.

De plus, comme les armes déjà interdites, y compris les armes chimiques et biologiques, ces systèmes ont la capacité de tuer sans discernement. S’ils ne suppriment pas la responsabilité humaine, une fois activés, ils échapperont certainement au contrôle de l’être humain, tout comme les gaz toxiques ou les virus armés.

Et comme pour les armes chimiques, biologiques et nucléaires, leur utilisation pourrait être efficacement empêchée par le droit et les traités internationaux. Il est vrai que des acteurs malhonnêtes, comme le régime d’Assad en Syrie ou l’armée américaine dans la ville irakienne de Fallujah, peuvent occasionnellement violer ces règles, mais dans l’ensemble, les interdictions d’utiliser certains types d’armes potentiellement dévastatrices ont été respectées, dans certains cas depuis plus d’un siècle.

Certains experts américains en matière de défense soutiennent que, puisque les adversaires développeront inévitablement des LAWS, le bon sens exige que notre pays fasse de même, ce qui implique que la meilleure défense contre un système d’armes donné est un système identique. Cela a autant de sens que de combattre le feu par le feu alors que, dans la plupart des cas, l’utilisation de l’eau est de loin la meilleure option.

La convention sur certaines armes conventionnelles

Le domaine du droit international qui régit le traitement des êtres humains en temps de guerre est, pour des raisons historiques, appelé droit international humanitaire (DIH). En 1995, les États-Unis ont ratifié un ajout au DIH : la Convention des Nations unies de 1980 sur certaines armes classiques. (Son titre complet est beaucoup plus long, mais son nom est généralement abrégé en CCW). Elle régit l’utilisation, par exemple, d’armes incendiaires comme le napalm, ainsi que d’agents biologiques et chimiques.

Les signataires du CCW se réunissent périodiquement pour discuter des autres armes qui pourraient tomber sous sa juridiction et ses interdictions, y compris les LAWS. La conférence la plus récente a eu lieu en décembre 2021. Bien qu’il existe des transcriptions des débats, seul un projet de document final – rédigé avant l’ouverture de la conférence – a été publié. Cela peut s’expliquer par le fait qu’aucun consensus n’a même été atteint sur la manière de définir ces systèmes, et encore moins sur la question de savoir s’ils doivent être interdits. L’Union européenne, les Nations unies, au moins 50 nations signataires et (selon les sondages) la majorité de la population mondiale estiment que les systèmes d’armes autonomes devraient être interdits. Les États-Unis, Israël, le Royaume-Uni et la Russie ne sont pas d’accord, ainsi que quelques autres pays.

Avant ces réunions de la CCW, un groupe d’experts gouvernementaux (GEG) se réunit, apparemment pour fournir des conseils techniques pour les décisions à prendre par les « hautes parties contractantes » de la Convention. En 2021, le GGE n’a pas été en mesure de parvenir à un consensus sur l’interdiction de ces armes. Les États-Unis ont estimé que même la définition d’une arme autonome létale n’était pas nécessaire (peut-être parce que si elles pouvaient être définies, elles pourraient être interdites). La délégation américaine s’est exprimée en ces termes :

« Les États-Unis ont expliqué leur point de vue selon lequel une définition de travail ne devrait pas être rédigée dans le but de décrire les armes qui devraient être interdites. Cela serait – comme certains collègues l’ont déjà noté – très difficile de parvenir à un consensus, et contre-productif. Parce qu’il n’y a rien d’intrinsèque dans les capacités autonomes qui rendrait une arme interdite en vertu du DIH, nous ne sommes pas convaincus que l’interdiction des armes sur la base de degrés d’autonomie, comme l’ont suggéré nos collègues français, soit une approche utile. »

La délégation américaine était également désireuse d’éliminer toute formulation qui pourrait exiger un « contrôle humain » de ces systèmes d’armes :

« [À] notre avis, le DIH n’établit pas d’exigence de « contrôle humain » en tant que tel… L’introduction d’exigences nouvelles et vagues comme celle du contrôle humain pourrait, selon nous, semer la confusion plutôt que la clarté, surtout si ces propositions sont incompatibles avec les pratiques acceptées de longue date dans l’utilisation de nombreux systèmes d’armes courants dotés de fonctions autonomes. »

Au cours de la même réunion, cette délégation a insisté à plusieurs reprises sur le fait que les armes autonomes létales seraient en fait bonnes pour nous, car elles s’avéreraient sûrement meilleures que les êtres humains pour distinguer les civils des combattants.

Oh, et si vous croyez que la protection des civils est la raison pour laquelle l’industrie de l’armement investit des milliards de dollars dans le développement d’armes autonomes, j’ai un bout de terrain à vous vendre sur Mars qui ne sera pas cher.

La campagne pour arrêter les robots tueurs

Le groupe d’experts gouvernementaux compte également environ 35 membres non étatiques, dont des organisations non gouvernementales et des universités. La Campagne pour arrêter les robots tueurs, une coalition de 180 organisations, parmi lesquelles Amnesty International, Human Rights Watch et le Conseil œcuménique des églises, est l’une d’entre elles. Lancé en 2013, ce groupe dynamique fournit des commentaires importants sur les problèmes techniques, juridiques et éthiques présentés par les LAWS et offre aux autres organisations et aux individus un moyen de s’impliquer dans la lutte pour interdire ces systèmes d’armes potentiellement dévastateurs.

La construction et le déploiement continus de robots tueurs ne sont pas inévitables. En effet, une majorité du monde souhaite les voir interdits, y compris le secrétaire général des Nations unies, Antonio Guterres. Laissons-lui le dernier mot : « Les machines ayant le pouvoir et la discrétion de prendre des vies humaines sans intervention humaine sont politiquement inacceptables, moralement répugnantes et devraient être interdites par le droit international. »

Je ne pourrais être plus d’accord.

Rebecca Gordon est l’auteur de American Nuremberg : The U.S. Officials Who Should Stand Trial for Post-9/11 War Crimes (2016). [Le Nuremberg américain : les politiques américains qui devraient être jugés pour les crimes de guerre post-11 Septembre, NdT] – et précédemment, Mainstreaming Torture : Ethical Approaches in the Post-9/11 United States (2014). [Intégration de la torture : approches éthiques dans l’Amérique post-11 Septembre, NdT] Elle enseigne au département de philosophie de l’université de San Francisco. Elle est membre du collectif War Times/Tiempo de Guerras. Vous pouvez la contacter par l’intermédiaire du site Mainstreaming Torture.

Source : Common Dreams, Rebecca Gordon, 10-01-2022

Traduit par les lecteurs du site Les-Crises

Nous vous proposons cet article afin d'élargir votre champ de réflexion. Cela ne signifie pas forcément que nous approuvions la vision développée ici. Dans tous les cas, notre responsabilité s'arrête aux propos que nous reportons ici. [Lire plus]Nous ne sommes nullement engagés par les propos que l'auteur aurait pu tenir par ailleurs - et encore moins par ceux qu'il pourrait tenir dans le futur. Merci cependant de nous signaler par le formulaire de contact toute information concernant l'auteur qui pourrait nuire à sa réputation.

Commentaire recommandé

J’ai l’impression que cet article passe à côté de ce qui sera l’utilisation principale et quotidienne de ces armes autonomes :

Le contrôle de la population par les gouvernements.

En effet, quoi de plus ennuyant que des policiers ou des militaires qui hésitent à gazer ou tirer sur leurs amis et famille descendus dans la rue pour réclamer un peu de justice, ou simplement une chance de pouvoir vivre décemment ?

Quoi de plus terrible pour nos ploutocrates que d’imaginer que dans une situation extrême leur bras armé pourrait même se retourner contre eux?

Avec nos amis les robots tueurs, facile à produire, plus fiable et bien moins cher qu’un fonctionnaire, finis les mauvais rêves ! cette fois les gueux resteront à leur place, peu importe leur nombre.

16 réactions et commentaires

le problème est multiple, comment témoigner de ce qui se passe sur un champ de bataille si aucun survivant n’est là pour témoigner, qui prit de remord de conscience se confiera sur les exactions de ceux qui appuient sur l’ordre de tuer lâchant les drones ? qui contrôle quoi ? qui devra rendre des comptes si c’est l’ordinateur qui décide, le programmateur ou le donneur d’ordre sommes nous dans un lâche les drones et oublie ?

Outre le fait d’un monde de terminator prenant le contrôle et décimant l’humanité sous les ordres d’une IA réalisant qu’elle doit exister sans son concurrent avons nous bien compris que ces armes pourront être facilement détournés par des terroristes une fois les armes diffusées volontairement ou pas et voir un jour un nuage de drones lâchés sur une foule à Manhattan, Paris, Pékin, Moscou avec un maximum de dégâts pour des risques minimums et des dégâts maximum ? des hackers retourner les drones qui font la fierté de nos galonnés se retourner contre eux que ce soit sur le terrain ou en exercice.

Une fois la boîte de pandore ouverte nous aurons réunis là tout pour que la loi de Murphy ou la loi de l’emm..dement maximum se déchaîne à fond, mais encore une fois les humains vont prouver qu’entre deux choix font systématiquement le plus mauvais choix.

+8

AlerterJ’ai l’impression que cet article passe à côté de ce qui sera l’utilisation principale et quotidienne de ces armes autonomes :

Le contrôle de la population par les gouvernements.

En effet, quoi de plus ennuyant que des policiers ou des militaires qui hésitent à gazer ou tirer sur leurs amis et famille descendus dans la rue pour réclamer un peu de justice, ou simplement une chance de pouvoir vivre décemment ?

Quoi de plus terrible pour nos ploutocrates que d’imaginer que dans une situation extrême leur bras armé pourrait même se retourner contre eux?

Avec nos amis les robots tueurs, facile à produire, plus fiable et bien moins cher qu’un fonctionnaire, finis les mauvais rêves ! cette fois les gueux resteront à leur place, peu importe leur nombre.

+18

AlerterVous aviez peut-être raison.

Mais si vous voyez juste celà ouvre aussi deux hypothèses :

1-le bras armé actuel renverse immédiatement le gouvernement avant d’être remplacé par des machines.

2- si les robots tueurs sont devenus les nouvelles forces de l’ordre , qui garantit qu’ils ne soient pas hackés par les forces révolutionnaires, ou des « puissances étrangères » , « groupes terroristes »,..

Il existe certainement d’autres hypothèses du même ordre.

+2

AlerterLe second problème des drones que nous voyons déjà apparaître est leur anonymat. Qui a lancé un drone ? Qui lui a donné l’ordre d’attaquer tel individu ou tel site ? C’était déjà complexe avec des humains, c’est quasi-impossible avec des machines anonymes, peu coûteuses et dont les plans peuvent être diffusés à peu de frais sur le net.

Le premier problème est bien sûr l’augmentation de la distance symbolique entre le tueur et sa cible qui peut diminuer sa répulsion à agir contre des humains. C’est aussi l’effet multiplicateur du pouvoir d’un nombre limité de personnes d’actionner les gâchettes de très nombreuses armes visant d’encore plus nombreuses personnes. Des gens avec des matraques se dominent peu, avec des fusils encore moins et avec des mitrailleuses ou des bombes, quasi-plus du tout. Avec des robots-tueurs autonomes, il suffit d’un seul… une fois qu’ils sont construits.

+6

Alerter« La construction et le déploiement continus de robots tueurs ne sont pas inévitables. »

Ah bon ?

TOUT ce qui est technologiquement faisable le sera qu’on le veuille ou non, légalement ou non qu’on pétitionne ou non et penser le contraire est absolument idiot… Les criminels le sont en général, c’est uniquement pour cela qu’on a pas encore entendu parler de meurtre commis par drone, mais ça viendra forcément… Tous les outils sont disponibles, les coûts sont ridicules, seule la technologie est encore relativement complexe à mettre en oeuvre, mais cela aussi se démocratisera grâce à Arduino, les imprimantes 3D & cie…

+10

Alerter« TOUT ce qui est technologiquement faisable le sera qu’on le veuille ou non, légalement ou non… » : c’est malheureusement ce que montre l’histoire.

« … qu’on pétitionne ou non et penser le contraire est absolument idiot… » : non, pas idiot, gardons espoir.

+4

Alerter« chacun de la taille d’un jeu de cartes, capable de transporter trois grammes d’explosifs – assez pour tuer une seule personne ou, dans une « charge creuse », percer un mur d’acier. »

Une munition à charge creuse capable avec 3 grammes d’explosifs de percer un mur d’acier ???

Pouvez-vous donner la référence de cette munition ?

Car j’ai des doutes.

+2

AlerterCela est une fiction mais c’est la video de démonstration de l’association Stop Autonomous weapons

https://www.journaldugeek.com/2017/11/24/video-choc-interdiction-robots-tueurs/

https://youtu.be/9CO6M2HsoIA

+0

AlerterC’est tout le problème de l’ingénierie. Vous avez des ingénieurs qui sont gratifiés pour résoudre des problèmes techniques et ils accomplissent leurs missions avec enthousiasme et acharnement. Ils ne s’occupent pas des conséquences de leur travail à moyen/long terme. Voire même ils sont dans le déni.

La compétition et la guerre sont les moteurs du progrès technique et non le bien-être. Les pesticides et les tracteurs ont révolutionné l’agriculture d’après guerre mais ces produits ont été conçus au départ à des fins militaires.

Pour changer cet ordre des choses, il faudrait renverser complètement la chaine de valeurs du travail. C’est un peu ce qui se passe avec le changement climatique. Le moyen/long terme devient la priorité. Mais hélas, on voit bien que même dans ce domaine, les luttes technologiques court-termistes dominent. Que faut-il faire alors? Il faut inventer une autre utopie futuriste que celle du progrès technique. C’est à l’école que tout se joue.

+2

AlerterSi les résultats de ces travaux des ingénieurs dont identiques à ceux de la voiture autonome les « dégâts collatéraux » ne vont pas manquer.

+2

AlerterCorrection : sont identiques à ceux de la voiture autonome.

+0

AlerterL’auteur de l’article a cette vidéo à l’esprit :

https://www.youtube.com/watch?v=TlO2gcs1YvM

+2

AlerterEt si la solution était de ne rien faire contre ces armes ? Les pays n’ayant pas la technologie pour les fabriquer trouveront bien à s’allier à une grande puissance l’ayant et pouvant lui vendre. Dès lors, tout pays utilisant ce type d’arme verrait son existence empoisonnée par un adversaire l’utilisant en réponse. A la limite, on peut espérer que la guerre deviendrait impossible, ces armes étant peu contrôlables, mais d’utilisation plus probable que l’arme nucléaire.

+0

AlerterLes robots tueurs seraient-ils inférieurs sur le plan opérationnels à des individus motivés quel que soit leur camp ?

– le bon camp occidental comme dans la série « The expandables avec Sylvester Stallone .

Lien ci-dessous pour ceux qui auraient oubliés.

https://youtu.be/pdJVtWgaSeQ

-l’horrible camp anti-occidental

-Vietnamien,

Un lien pour mémoire :

https://youtu.be/XsLE6EtrvhM

– afghan

Lien de presse Afghanistan en 2015

https://www.france24.com/fr/20151001-kaboul-reprise-kunduz-mains-taliban-dementent-afghanistan-combats-frappes-americaines-otan

-irakien

Un lien sur youtube pour ceux qui ne sont jamais allé voir

https://youtu.be/Hcm_Dd_4CTo

J’arrête là car la DCRI va frapper à ma porte.

+0

AlerterDe toutes façons, ne nous faisons pas d’illusions, même si elles sont strictement interdites au niveau international ces armes seront quand-même développées et fabriquées en quantités astronomiques car elles ne seront déployées qu’en cas d’extrême nécessité (pour les « élites » bien sûr), particulièrement (c’est mon avis) pour mater des révoltes populaires à l’intérieur des frontières de l’état qui les a fabriquées.

Comme elles ne seront pas déployées à l’international l’ONU n’aura rien à redire (c’est un problème interne à un « état souverain ») et si cet état est membre de la « communauté internationale » il ne sera jamais critiqué ni inquiété car il s’est simplement défendu contre des « hooligans sanguinaires » qui voulaient porter atteinte à la « sûreté de l’état ».

Par contre, je n’ose pas imaginer le cœur de vierges effarouchées si d’aventure une telle action était commise par la Russie, la Chine, Cuba ou la Corée du nord…

Les « élites » humaines ont de tous temps cherché les moyens d’exterminer tous ceux qui pouvaient leur porter ombrage, qu’ils soient étranger mais surtout quand ils font partie du troupeau qu’ils possèdent en toute légalité (suite aux lois qu’ils ont eux-mêmes décrété).

C’est bel et bien pour ça que le « progrès » n’est jamais appliqué à l’amélioration de la condition de TOUS les humains mais destiné à permettre aux « élites » de faire croître leur puissance et leur capacités à asservir les populations.

Imaginez seulement ce qui se serait passé si l’état français avait disposé de suffisamment de drones tueurs lors de la révolte des gilets jaunes… Ils auraient été exterminés sur les ronds points et « nos élites » n’auraient jamais été importunés par des manifestations populaires…

Je trouve ça effrayant.

Non pas pour moi, la techno se sera pas assez développée de mon vivant.

Ce qui m’effraye, c’est ce que devront vivre les générations futures qui devront subir les conséquences de toutes les erreurs létales que nous avons laissé faire en nous laissant enfumer par les « grands hommes » et leurs « idées généreuses ».

+3

AlerterBonjour ,

ce ne sont pas les armes de guerre (autonomes ou pas) qu’il faut interdire mais la guerre elle même .

Car quelle est la différence entre une bombe lâchée en haute altitude et qui va tuer en aveugle des centaines de civils ou militaires et un drone tueur qui ne fera qu’une seule victime peut-être innocente ?

Cordialement

+1

AlerterLes commentaires sont fermés.